Afin d’être en mesure de suivre l’analyse qui sera faite ici, il convient de faire un petit détour de l’analyse et de présenter les éléments techniques et théoriques dans lesquels je vais puiser. Premièrement, le fonctionnement du son dans la console conditionne énormément les possibilités musicales. Cela signifie qu’avec les contraintes techniques et matérielles imposées par le système, la musique ne pourra pas prendre toutes les formes voulues. Nous le verrons juste après, Nobuo Uematsu a su ruser pour détourner ces contraintes, voire les manipuler pour en soutirer une force. Ensuite, puisque je m’intéresserai à la fonction narrative de la musique, il me semble essentiel de définir les contours du milieu. Cela comprend les différentes mécaniques utilisées pour signifier quelque chose en utilisant le matériaux musical. La question de la signification de la musique est un grand débat en musicologie. Je ne rentrerai pas dans le débat lors de cette analyse, car aucun consensus n’est aujourd’hui établit pour définir une science du sens musical et ma légitimité m’empêche de m’y insérer. Je vais en revanche discuter de l’ambivalence qui existe entre le « thème » musical et le « leitmotiv ». Une fois ces éléments posés, il sera malgré tout possible de tirer des conclusions sur le lien entre musique et narration sans aller chercher trop loin. Pour cela il faut comprendre comment fonctionne la musique, et c’est sur ce point précis que j’ai insisté dans les premières pages de cet ouvrage. Ne vous inquiétez pas, je vais faire tout ce qui est en mon pouvoir pour détailler au maximum, quitte à me répéter ou à perdre le temps d’un instant, le fil de l’analyse. Et je m’excuse par avance si la lecture en devient fastidieuse. C’est pour cette raison que dans cette petite introduction sur la musique de la NES et plus largement la musique à l’image, je vais balayer quelques concepts une bonne fois pour toute.

Introduction au fonctionnement du son dans la NES

Les jeux qui nous intéressent ici sont sortis entre 1987 et 1990 sur la console de salon de Nintendo, la Famicom, renommée Nintendo Entertainment System (NES) lors de son exportation à l’international. Si l’on met de côté tous les détails techniques qui existent entre ces deux versions d’un même système, et leurs différents constructeurs, impliquant des puces parfois légèrement différentes, et que l’on s’intéresse uniquement à la puce sonore de la console ; son fonctionnement est extrêmement simple et abordable.

La NES permet de faire entendre du son grâce à cinq « canaux audio », que l’on peut voir comme cinq pistes différentes. Trois d’entre eux peuvent synthétiser des formes d’ondes et les deux derniers sont réservés respectivement à un canal de bruit blanc, utile pour les sons percussifs ; et à la lecture de d’échantillons sonores de très basse qualité. Les canaux qui nous seront utiles sont ceux permettant de synthétiser une forme d’onde. La NES utilise, sur toutes ses versions, la puce RP2A03 du constructeur Ricoh. Cette dernière est, grâce à Yukio Kaneoka, capable de générer des formes d’ondes via à un Générateur Programmable de Son (Programmable Sound Generator ou PSG en anglais). Celui-ci permet la synthèse de formes d’ondes simples, c’est-à-dire des formes d’ondes dérivées de la sinusoïde, et ayant des caractéristiques particulières. Deux des trois canaux peuvent ainsi générer des formes d’ondes « carrées » ou « rectangulaire » – que l’on nommera ici Pulse Wave ou PW – selon la programmation souhaitée, tandis que la troisième utilisera une forme d’onde « triangulaire » ou TW pour Triangle Wave. Si la forme d’onde triangulaire a des propriétés bien établies et ne peut pas être modulée, la forme d’onde rectangulaire peut faire entendre trois principaux timbres différents selon son paramétrage. A l’instar de la sinusoïde, ce que l’on appellera la Pulse Wave, oscille entre des valeurs arbitraires 1 et -1, où 0 représente l’absence de son. Seulement, là où la sinusoïde ne reste pas sur sa valeur 1 ou -1, la Pulse Wave permet de rester sur ce plateau, et passera directement à la valeur -1 par la suite1. Ce qui permettra de changer le timbre de la Pulse Wave sera le temps consacré au premier plateau. Ainsi, il est par exemple possible d’avoir une onde parfaitement carrée, de rapport 50/50, et deux formes d’ondes rectangulaires de rapports 25/75 et 12,5/87,5. En résultent trois sons différents, que les compositeurs et programmeurs utiliseront pour faire varier le timbre des « instruments » de leurs œuvres. Bien entendu, il est possible de moduler la forme d’onde afin de passer d’un rapport à l’autre de manière progressive. Enfin, puisqu’une image vaut plus qu’un beau discours, voici à quoi ressemblent ces différentes formes d’onde :

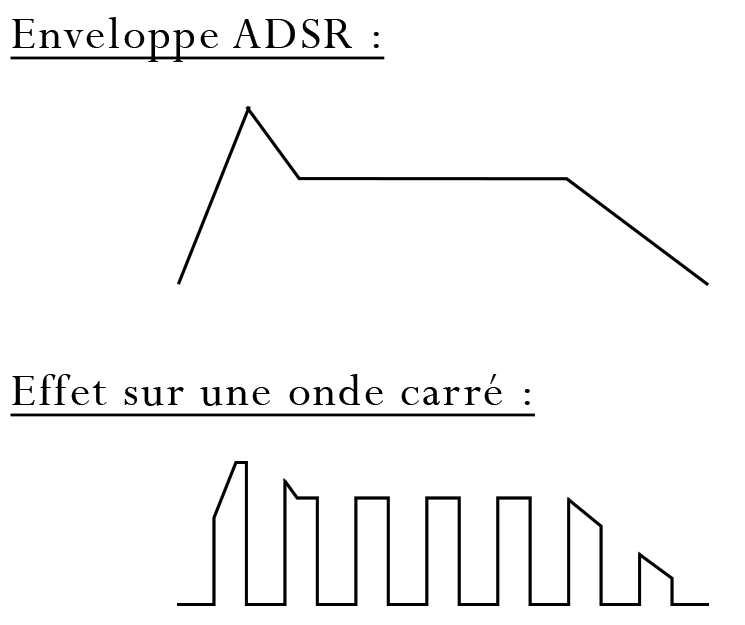

Une fois la forme d’onde générée, il est possible de lui donner une enveloppe. Cette enveloppe sera utile pour ajouter de la musicalité au son. Il faut comprendre par-là que, si l’on attaque une forme d’onde trop rapidement, sans prendre de précautions, un « clip » sera entendu, et l’intensité sonore, l’amplitude de l’onde, restera constante. L’enveloppe utilisée est dite « ADSR » pour Attack, Decay, Sustain, Release, que l’on peut traduire en français par Attaque, Diminution, Maintient, Relâchement. Cette enveloppe va moduler l’amplitude de la forme d’onde en suivant quatre étapes :

- L’Attack va faire progresser l’amplitude de 0 à la valeur souhaitée (1 pour un son fort, 0,5 pour un son moyennement fort, etc…). Le temps, en millisecondes, pour passer de 0 à la valeur souhaitée va dépendre des intentions du compositeur/programmeur.

- Le Decay va faire diminuer l’amplitude de la valeur haute atteinte par l’Attack à une autre valeur, nécessairement inférieure mais toujours supérieure à 0. En général, le temps de Decay est très court.

- Le Sustain va conserver le niveau d’amplitude de l’onde laissée par le Decay durant un certain temps, dépendant de nouveau des souhaits du compositeur/programmeur.

- Enfin, le Release va réduire l’amplitude de l’onde à 0 sur un certain laps du temps, vous avez compris.

Schématiquement, cette enveloppe a cette forme, et j’ai ajouté en dessous son effet sur une forme d’onde carré. Bien entendu, les échelles ne sont pas respectées pour mettre en avant l’effet d’une telle enveloppe :

Enfin, dernière information importante, les canaux audios sont monophoniques. Cela implique énormément de contraintes sur la composition. Nous avons vu que la NES utilise trois canaux pour synthétiser des formes d’ondes à différentes fréquences, dont en résulte une note de musique. Un canal monophonique signifie que chaque canal n’est capable d’héberger qu’une forme d’onde. En des termes plus musicaux, cela signifie que chaque canal ne pourra faire entendre qu’une seule et unique note à la fois. Et ces canaux valent aussi pour le Sound Design. Si un jingle d’ouverture de coffre doit être joué, celui-ci prendra la mémoire nécessaire à l’utilisation d’un ou plusieurs canaux, au détriment de la musique. La musique s’arrêtera alors de jouer, ou continuera son parcours en omettant les notes associées aux canaux exploités par le jingle en question.

La musique occidentale tonale est régie par des notes formant des accords. Le plus simple accord possible est un accord dit « à trois sons »2, utilisant alors trois notes en simultané. Par exemple, l’accord de Do Majeur est formé par les notes Do, Mi,et Sol. Ces accords sont appelés des « triades ». Avec l’architecture de la NES, il est alors possible de faire entendre n’importe quelle triade sans trop de soucis. Mais le compositeur peut également souhaiter utiliser d’autres accords, utilisant quatre, cinq ou six sons. Ces accords, enrichis, portent respectivement le nom d’accord de septième, de neuvième ou de onzième. Les problèmes surgissent lorsque l’on veut faire entendre en simultané quatre notes ou plus, avec à sa disposition uniquement trois canaux monophoniques. Heureusement, les accords de septième et de neuvième peuvent aisément se séparer de leur quinte qui n’apporte aucune information quant à leur couleur. Les accords de septième sont donc facilement jouables en supprimant leur quinte, puisque l’on rabat les informations nécessaires à trois notes au lieu de quatre. Reste que les accords de neuvième et de onzième nécessitent pour leur bonne réalisation, que la tonique, la tierce, la septième et la neuvième et/ou la onzième soient jouées en même temps, donc quatre à cinq sons. Et là, ça coince. On constatera à travers une analyse exhaustive de toute la musique de Final Fantasy I3, Final Fantasy II, et Final Fantasy III qu’aucun accord de cinq sons, ou plus, ne sera jamais entendu en l’état. Ceci constitue notre première contrainte de composition.

Fort heureusement, les compositeurs, dont Nobuo Uematsu, ont su ruser afin de faire entendre des accords particuliers nécessitant l’utilisation de plus de trois notes en simultané. C’est le cas pour l’accord de septième diminuée, dans lequel chacune des quatre notes est importante pour la bonne conduite de l’harmonie. Juste avant, je précisais que les accords de septième pouvaient se passer de leur quinte. Ceci vient du fait que la « quinte » telle qu’appelée aussi sobrement, est dite « juste ». Si l’on regarde ce qu’il se passe du point de vue acoustique et ce de manière très basique, on remarque que la quinte juste n’est qu’un renforcement des harmoniques de la tonique. Or, dans un accord de septième diminuée, la quinte n’est plus juste mais diminuée. Elle rajoute alors plus d’informations à la couleur de l’accord et devient de fait légèrement plus nécessaire à la bonne écoute de ladite couleur. De ce fait, il n’est plus question de la supprimer, bien qu’un accord de septième diminuée sans sa quinte conserve grossièrement sa couleur « diminuée ». La quinte diminuée devient donc nécessaire, et le compositeur est contraint de faire entendre les quatre sons. Lors de l’utilisation de tels accords, le stratégie a été de les arpéger très rapidement, laissant alors trainer dans l’oreille de l’auditeur, la note précédente tandis que la prochaine surgit déjà. Nous voyons un premier exemple d’une telle utilisation dans l’arpège de septième diminuée entendu à chaque début de combat dans la piste intitulée Battle I4:

Ici, l’effet est encore mieux réalisé, puisque la Pulse Wave 2 joue le même accord avec un délai, faisant office d’écho, et permettant de superposer systématiquement deux notes de l’accord. Nous retrouvons beaucoup d’utilisations astucieuses des arpèges pour augmenter la couleur de l’harmonie malgré une contrainte technique et matérielle. Comme on le dit souvent, nous agissons plus efficacement sous contrainte, puisque la contrainte nous pousse à dépasser les limitations techniques pour réaliser ce que l’on souhaite.

Pour programmer les sons sur la NES, les compositeurs devaient, à l’époque, coder eux-mêmes ou avec un programmeur à leur côté, directement les sons dans la puce. Il ne sera pas question ici de rentrer dans les détails d’un tel procédé, mais il est cependant intéressant de comprendre les enjeux d’une telle tâche. Le driver sonore de la NES est programmé en assembleur, c’est-à-dire un langage de programmation à la base de l’échelle, un langage extrêmement basique et qui représente le premier niveau de lecture entre ce que peut comprendre un humain en lisant ce code, et ce que peut effectuer la machine. Pour plus de précision, la NES utilise le langage assembleur « 6502 » qui possède ses propres caractéristiques.

Chaque bit est programmé à la main. Et là, nous allons devoir rentrer un petit peu dans le dur du sujet.

Chaque canal de la NES possède ses propres caractéristiques rassemblées sous la forme d’un octet, c’est-à-dire une chaine de 8 bits. Les possibilités laissées par ces octets dépendent du canal. Il n’est ainsi pas possible pour le canal 3 utilisant la forme d’onde triangulaire de modifier le volume de celle-ci durant son jeu. Pour vous donner un exemple du type de programmation attendu pour utiliser une unique note sur le canal 1, je vais tenter de vous expliquer comment la programmation fonctionne. Le canal 1 utilise donc une forme d’onde rectangulaire et est adressée de $4000 à $4003 dans la mémoire de la puce5. Elle possède donc 4 adresses qui fonctionnent comme suit :

- $4000 : utilise 8 bits sous la forme CCDC’ VVVV où C détermine le cycle de l’onde rectangulaire codé sur 2 bits, D gère la durée de la note en association avec les valeurs indiquées en $4003, C’ détermine si le volume est constant ou non et V détermine le volume. Une chaine 0000 signifie le silence, et 1111 que le volume est au plus fort. Sur cette adresse on indique donc la forme d’onde rectangulaire souhaitée (50%, 75%…), et les indications de volume, soit la forme et l’amplitude de l’onde.

- $4001 : utilise 8 bits sous la forme EPPP NSSS. Cette adresse est utilisée pour faire des glissandi. E permet de déterminer si le glissandi est effectif, P indique la période du glissandi, N inverse la rampe, par défaut ce sera un glissandi montant. Et S permet d’insérer un décalage dans la rampe.

- $4002 : utilise 8 bits pour coder la fréquence de l’onde sous la forme TTTT TTTT. C’est ici que l’on détermine la note à jouer. Ce sont ici les 8 premiers bits pour contrôler la fréquence, avec les 3 derniers bits disponibles en $4003 si nécessaire.

- $4003 : utilise 8 bits sous la forme LLLL LTTT où L (Length, que je laisse volontairement en anglais pour ne pas rentrer en conflit avec D de durée déjà utilisé) détermine la durée de la note si D de $4000 est laissé à 0, et T indique les trois derniers bits de la valeur assignée à la fréquence de la note. C’est légèrement plus compliqué, mais cela n’a pas grande importance pour notre démonstration.

Maintenant que l’on a toutes les données nécessaires pour coder une note, on peut programmer chaque 1 et chaque 0 sur les quatre adresses pour faire jouer une simple et unique note dans le canal 1. Si l’on souhaite utiliser une onde rectangulaire carrée de cycle 50%, on adressera $10 à C dans $4000, on laisse D à $0 pour utiliser le paramètre de durée disponible en $4003, C’ à $1 pour avoir un volume constant, et on va utiliser un volume moyen (50%) en indiquant 0111 dans V. L’adresse $4001 ne sera pas utilisée puisqu’elle est très spécifique. Pour la note indiquée en $4002, si je souhaite faire entendre un Do3 de fréquence 261.63Hz, j’indique 001101016. Pour avoir une note de durée maximale j’indique $11111 à L dans $4003, et on ajoute les trois bits restant à la valeur correspondant à Do3 à T, donnant $010.

Ainsi, pour avoir un Do3 de durée maximale, de volume moyen avec une onde carrée et de fréquence constante, j’indique :

- $4000 : 10010111

- $4001 : 00000000 (inutilisé dans l’exemple, les valeurs ne sont probablement pas justes)

- $4002 : 00110101

- $4003 : 11111010

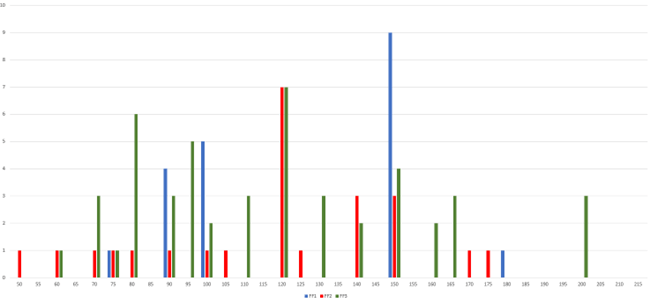

Tous ces efforts permettent de programmer une seule note sur un seul canal. Sachant que pour un enchaînement musical, il faut calculer la valeur binaire de la durée de chaque note pour éviter les conflits, entre autres paramètres comme l’enveloppe de l’onde et les tremolos. La programmation musicale sur la NES est donc très fastidieuse, et les limitations en mémoire renforcent les contraintes. Cette petite disgression technique permet de mettre en avant une donnée importante pour comprendre en partie la musique de la NES. On voit ici que chaque petite musique est un réalité un exploit à part entière. Cette dimension permet de justifier plusieurs aspects de la musique des Final Fantasy. On remarquera en effet que, si l’on prend la liste complète des musiques de Final Fantasy I, on a au total 3 tempi différents : 75, 90, 100, 150 (75) et 180 (90) battements par minute (bpm)7. Ici, la valeur binaire à entrer pour, disons, une croche à 110 bpm, dépend de la fréquence du CPU de la puce audio. Ce qui signifie que la valeur de la croche à 110 bpm ne sera pas la même que pour une croche à 150 bpm. Ni même que pour une croche à 109 bpm. On comprend alors rapidement la nécessité de ne pas multiplier les bpm afin de simplifier au maximum la fastidieuse tâche de programmation. Fort est à parier que Nobuo Uematsu possédait une table des valeurs pour des tempi de référence. Si l’on regarde un peu plus loin, Final Fantasy II possède légèrement plus de tempi différents, et Final Fantasy III explore encore d’autres horizons8 :

Pour effectuer cette figure, j’ai pris en compte les « erreurs » de relevé : un tempo de 148 relevé pourrait en réalité être un tempo de 150, plus conventionnel et utilisé sur plus de musiques en commun. Il existe donc une légère valeur arrondie dans les faits. De plus, une machine ou un programme ne fait pas de distinguo entre une mesure binaire ou ternaire. Ainsi, les tempi ternaires (6/8, 12/8 principalement) ont été ramené à leur valeur binaire. On peut également réduire la taille de cette figure si l’on remarque qu’il existe une corrélation entre les tempi à 50 bpm et 100 bpm, ou 70 et 140. En soi, les tempi doublés peuvent être ramené à une unique valeur, réduisant de ce fait les possibilités. En effet, programmer une noire à 140 bpm revient à programmer une croche à 70 bpm ou inversement, toutes les équivalences pouvant être valables. Ce faisant, nous obtenons la figure suivante :

Nous voyons grâce à ce graphique que Final Fantasy I ne possède en réalité que 3 tempi différents (100, 150 et 180), allant jusqu’à 10 pour le second et troisième épisode. Le tempo est alors assez formaté.

Nous avons donc deux dimensions qui sont formatées : la hauteur des notes et l’harmonie qui sont limitées par le nombre de canaux utilisables en simultané, et les différents tempi qui demandent une certaine agilité en programmation mais qui sont, chez Final Fantasy en tout cas, réduit à quelques valeurs « rondes » (100, 105, 110 par exemple) afin d’être en mesure de générer une table de valeurs utiles à la programmation presque artisanale de la musique.

La question de la signification

La sémantique est un large débat en musicologie. La question qui est systématiquement soulevée est : « la musique permet-elle de signifier quelque chose ? ». Cette question, bien qu’essentiellement irrésolue, est pleine de sens. Pour signifier quelque chose, notre système de communication est basé sur la génération de signes. Ces signes, codés et formatés par notre culture de groupe ou personnelle, permettent de véhiculer une information. Ils peuvent prendre plusieurs forme comme un graphisme, un dessin, ou encore un son, la voix, développé dans une syntaxe nommée langage. Je reprends l’idée du code de la route utilisé dans le préambule : ce « code » est constitué de symboles, de logos, de graphismes au sens large, qui permettent de véhiculer un sens. Un panneau de forme ronde possédant un anneau rouge sur son périmètre intérieur signifie une interdiction. Le symbole situé au centre de ce panneau donne la nature de l’interdiction : stationnement, circulation, vitesse, etc. Il y a donc une syntaxe qui est créée : le symbole « interdiction » associé au symbole décrivant ce qui est concerné. Dans la même idée, le signe de la « flèche » permet de véhiculer une information. Une flèche seule ne signifie pas grand-chose. Mais une flèche placée dans un contexte précis permet d’indiquer une direction à suivre, ou un sens de circulation. Pour se rendre compte de cela il suffit d’imaginer une situation où le sujet se trouve dans un lieu quelconque et se retrouve devant une flèche (sur un panneau ou au sol). Que signifie la flèche ? Sans autre information, elle ne signifie pas grand-chose : une direction, un sens, mais vers quoi ? On ne sait pas. La flèche seule n’a donc ici pas de sens. Si l’on ajoute un autre signe juxtaposé à cette flèche (un dessin de maison, par exemple) la syntaxe « Flèche + maison » nous indique alors que dans cette direction se situe une maison. La sémantique est donc assez tributaire de la syntaxe. Il faut associer des idées, des symboles, des signes, pour signifier quelque chose. Le sens de juxtaposition est également une information importante. Si le symbole de la maison est placé avant, après ou autour de la flèche, le sens ne sera pas tout à fait le même. Il existe également, en sémantique, ce que l’on appelle des « inénonçables », « non-énonçables » ou « inexprimables ». Ce sont des énonciations qui, une fois exprimées, véhiculent un sens dissonant. Prenons l’exemple « Ma mère est […] ». Nous avons ici une phrase qui possède plusieurs éléments : Ma est un possessif, indiquant que l’on va parler d’un élément attribué au locuteur, mère fait référence au lien biologique entre le locuteur et l’élément qui sera décrit par la suite grâce à l’auxiliaire est. Nous avons donc une phrase qui va décrire l’ascendant biologique féminin du locuteur9 avec l’élément manquant […]. Nous pouvons alors par exemple utiliser un adjectif, « grande », pour préciser que la mère du locuteur est de grande taille : ma mère est grande. Cette phrase est parfaitement énonçable. Ou encore, donner la nature de l’activité professionnelle de la mère : ma mère est infirmière. Mais il est possible de créer une dissonance en utilisant un terme, un signe, qui n’a rien à voir avec le reste de la phrase : ma mère est un cheval ou ma mère est un tabouret. Ces locutions sont dites non-énonçables, car nous ne pouvons pas, dans les faits, les énoncer pour véhiculer un sens. En d’autres termes, cette locution ne veut rien dire.

Bien entendu, tous ces exemples sont complètement subjectifs. Peut-être existe-t-il une culture où la locution Ma mère est un cheval possède un sens bien précis et culturellement établit. C’est ici que le bât blesse. Les conditions de compréhension d’un énoncé, si l’on met de côté toutes les théories sophistiquées sur la sémantique du langage, sont dépendant de la culture dans laquelle l’énonciation est déclarée. En effet, les signes renvoient à des images mentales qui sont établies. Si je vous dis « table » vous avez immédiatement en tête l’image d’une plaque, généralement en bois, soutenue par quatre pieds disposées en ses coins, servant à poser des objets dessus. De même que si je vous dis « chien » vous avez l’image d’un animal poilu possédant quatre pattes, une queue, des oreilles dressées et encore pleins d’autres éléments caractéristiques. Cette description sommaire ne décrit, bien entendu, pas parfaitement un chien (cela pourrait être un chat, un cheval ou un lapin), mais pour la simplicité de l’exercice je n’irai pas plus loin dans la description de l’élément « chien ». Ainsi, un signe renvoie à une représentation mentale, ce que Charles Peirce appelle dans sa triade le Representamen. Le Representamen est associé à l’Interprétant, c’est-à-dire le sujet qui s’occupe d’interpréter le signe, et l’Objet concret de cette interprétation, sa réalité dans le monde physique. Ces mécaniques cognitives d’interprétation des signes est extrêmement complexe et constitue un domaine de recherche à part entière. Je n’en ferai pas une description plus poussée ici.

Qu’en est-il de la musique ? Dans la même idée, la musique est une associations de signes qui sont interprétés. Il y a, de prime abord, l’agent qui exprime le geste : le musicien qui joue du violon. Ce sera notre locuteur. D’un autre côté, il y a le sujet qui reçoit le signal joué par le musicien. Appelons-le le destinataire. Si le locuteur veut signifier quelque chose de précis au destinataire en utilisant uniquement son violon, il se retrouvera bien embêté. Comme le dit si bien Jean-Jacques Nattiez :

Jamais une œuvre musicale ne nous dira quelque chose comme « Longtemps je me suis couché de bonne heure ». Sinon, il n’y aurait pas de différence entre la musique et le langage comme formes symboliques.10

Un musicien ne pourra jamais vous quémander d’aller chercher du pain à la boulangerie en utilisant son langage musical. Sauf si cette demande a été codée entre vous. Vous aurez alors développé, à petite échelle dans votre culture commune, un langage musical. C’est exactement ce que nous allons faire ici. Mais en l’état, ex nihilo, la musique ne peut pas véhiculer de sens (précis, en tout cas). C’est dans l’enchainement d’évènements musicaux que nous sommes en mesure d’établir ce que Nattiez appelle un proto-récit. Ce qui nous intéresse ici est la notion d’évènement. Nous pouvons créer un sens en musique si l’on regarde l’enchainement des évènements musicaux :

La validité de l’applicabilité de la notion d’événements à la forme d’art ou à l’objet étudié est donc une condition nécessaire pour le développement de réagencements temporels dans la représentation narrative, mais ce n’est pas une condition suffisante.[…] Or, il arrive à de nombreux auditeurs et interprètes de se référer à un certain nombre de moments dans un morceau musical en affirmant qu’ils constituent des événements, c’est-à-dire des passages dans lesquels quelque chose de distinct arrive, c’est-à-dire quelque chose qui diffère nettement de la plupart des choses qui précèdent et qui suivent.11

Ici, Michael Toolan indique que nous sommes en mesure de créer une narration, donc un sens, si l’on s’intéresse aux évènements : « avant (ou après) ceci, il s’est passé ‘’ça’’ ». Cet enchainement de « ceci » et « ça » peut donc posséder un sens. « Avant, les violons jouaient seuls, puis après le trombone est arrivé » ou encore « Après l’accord de septième diminuée, […] ». Ce proto-récit est la première porte d’entrée dans l’interprétation sémantique et narrative de la musique. Que signifie l’arrivé du trombone ? Il peut à la fois tout et rien signifier. Cela dépend du contexte d’apparition mais surtout du contexte culturel établit. Si dans cette œuvre le trombone possède une signification particulière, alors son apparition ou sa disparition possèdera un sens. On n’attribue donc pas le sens à proprement parler à la musique en soi, en tant que phénomène, mais à la mise en contexte de celle-ci grâce à la notion d’évènement.

C’est exactement en suivant cette mécanique évènementielle que la musique de jeu vidéo, ou, d’une manière plus étendue la musique « à l’écran », fonctionne. Il est possible de trouver du sens selon plusieurs niveaux de lecture : dans une composition, ou dans l’agencement, les interactions et le jeu de réponse entre les tableaux musicaux. Au niveau de la composition, le sens peut avoir plusieurs dimensions : harmoniques, mélodiques, rythmiques, tout à la fois ou quelques paramètres isolés, etc… Pour l’interaction entre les compositions, nous regarderons les éléments communs, et bien entendu les éléments différentiels. La distance séparant deux occurrences possède également un intérêt : deux musiques rapprochées n’auront pas la même signification si ces deux musiques sont, à un autre moment, éloignés dans l’intrigue. Se créé alors un réseau complexe d’interactions entre les musiques, les thèmes et les leitmotiv permettant, sur le long terme, ou un a une échelle macro, de générer un sens narratologique en lien avec ce qu’il se passe à l’écran.

Une distance relativement importante entre deux évènements musicaux possède une contrainte principale : la mémoire du joueur ou du spectateur. A l’inverse du film qui est, dans la majorité des cas, consommé d’une traite ; le jeu vidéo est rarement joué lors d’une seule et unique session12. Vient alors une double mécanique de mémoire : celle à l’intérieur d’une session de jeu, plus ou moins longue selon les cas, et celle entre les sessions qui peuvent, à nouveau, prendre des proportions importantes ou non. Ainsi, afin de répondre à cette contrainte, les éléments narratifs musicaux seront rappelés tout au long de l’intrigue. Ce sont les thèmes principaux, ou les leitmotive récurrents qui reviendront çà et là au fil des musiques entendues lors du parcours vidéoludique du joueur.

Ainsi, pour synthétiser cette réflexion à peine entamée sur la signification musicale, nous avons un système auditif constitué de signes divers et variés : un accord d’une couleur particulière, ou un instrument précis, par exemple. En l’état, ces signes ne possèdent pas de sens réel si une convention n’a pas été établie lors de la narration intrinsèque de l’œuvre. Un accord majeur seul n’a pas de signification particulière dans une œuvre musicale. En revanche, là où cela devient intéressant, c’est lorsque l’on assemble les signes pour créer une syntaxe. Un accord majeur suivit d’un accord diminué, ou, pour reprendre l’exemple précédent, des violons suivis d’un trombone, possède un sens. Ce sens-là n’est pas absolu et ne sera pas systématiquement le même d’une œuvre à l’autre. Ce sens est interprété à l’aide de tous les éléments sensoriels associés : la narration propre à l’œuvre (le scénario, les dialogues…), les images par-dessus laquelle la musique joue (l’écran), etc… De même, l’association de différents morceaux de musique juxtaposés ou éloignés possèdent un sens. Une musique de donjon, associée au danger, suivit d’une musique de ville, associé au repos ; signifie le « retour au calme », et l’inverse signifiera « l’arrivée du danger »; pour un cas très trivial.

- Bien que mathématiquement la Pulse Wave passe instantanément d’une valeur à l’autre, en réalité, le passage se fait très rapidement et progressivement. Il est alors possible de modifier le temps alloué à cette transition, créant des timbres différents. ↩︎

- Si l’on associe deux sons, on appelle cela un intervalle : Do – Mi représente une tierce majeure, tandis que Mi – Do représente une sixte mineure. Avec un seul son, nous avons… une note. ↩︎

- On nommera Final Fantasy I le premier jeu de la série, bien que celui-ci ne porte pas de numérotation dans son nom d’origine. Cette petite liberté est prise pour séparer les instants où nous parlerons de la série dans son ensemble, ou de ce jeu en particulier. ↩︎

- A l’instar de la note précédente, les pistes musicales utilisant des titres similaires entre les jeux, comme celle des musiques de combats Battle se verra librement ajouté le numéro du jeu auquel elle appartient pour plus de confort. ↩︎

- Le signe $ est utilisé pour signifier un adressage en binaire. ↩︎

- Je vous passe la formule à appliquer pour trouver cette valeur, mais on trouve la valeur 11 bits suivante : 00110101010. ↩︎

- Comme je l’explique plus tard, je réduis à 3 le nombre de tempi car un tempo à 75 bpm est équivalent à 150 bpm si l’on double le rythme. Une croche à 75 bpm équivaut à une noire à 150 bpm. Donc ici, pour donner l’illusion d’un tempo plus rapide ou plus lent, on accélère ou ralenti, par un facteur 2, la durée des rythmes. ↩︎

- Les tempi relevé dans cette figure sont à titre relativement indicatifs. Il est probable que leur justesse soit légèrement différente en réalité, mais la différence entre un tempo de 110 bpm et 111 bpm est extrêmement subtile sur une musique qui ne dure quelques dizaines de secondes tout au plus. ↩︎

- Passons rapidement sur ce qui constitue réellement une « mère », qui peut également être adoptive. Cette précision n’a aucune importance dans la démonstration. Je prendrais ici l’exemple d’une mère biologique ayant donné naissance au locuteur qui énonce la phrase considérée. ↩︎

- NATTIEZ Jean-Jacques, La narrativisation de la musique. La musique : récit ou proto-récit ?, Cahiers de Narratologie [En ligne], 2011, p3. ↩︎

- TOOLAN Michael, La narrativité musicale, Cahiers de Narratologie [En ligne], 2011, p1. ↩︎

- Mettons de côté les cas particuliers que sont le Speedrun ou les jeux très courts pouvant être parcouru en un temps minime. Ce n’est pas le cas des jeux concernés par cet ouvrage. ↩︎